Le SDART a été défini et construit en fonction des contraintes techniques de l’époque. Il n’est pas inutile de se rappeler le contexte de l’informatique et des télécommunications des années 70 pour mieux comprendre la logique industrielle et technique de sa construction.

Les débuts de l’informatique industrielle

Avant le SDART, l’informatique avait déjà fait son apparition à EDF, notamment dans le domaine de la gestion et même dans les dispatchings, alors équipés de calculateurs appelés « 9040 ». L’informatique n’était donc pas tout à fait une nouveauté, mais elle était en plein développement. Les années 70 ont été marquées par la diminution de la taille des ordinateurs. On découvrait alors la « mini-informatique » et ses « mini-ordinateurs », pouvant contenir dans une seule armoire l’ensemble du matériel nécessaire à leur fonctionnement. Les premiers d’entre eux ne disposaient que de 16 kilo-octets de mémoire. Mais cela annonçait déjà la « micro-informatique » qui permettra dans la décennie suivante l’éclosion du PC (Personal Computer) d’IBM en 1981 ou le Macintosh d’Apple.

Les concepts comme le vocabulaire étaient encore très instables, et la programmation restait très proche des mécanismes de base de la machine utilisée. Les langages de haut niveau faisaient leurs premiers pas, mais le recours au langage machine, appelé « l’assembleur », restait souvent nécessaire pour répondre aux contraintes des traitements en temps réel.

Dans ce contexte de découverte du potentiel de l’informatique pour remplir des fonctions de téléconduite, les produits industriels n’existaient pas encore. Tout au plus pouvait-on parler de solutions prototypes. Les efforts portaient aussi bien sur la demande que sur l’offre, à ajuster progressivement l’une à l’autre.

L’un des principaux enjeux consistaient à faire communiquer l’ordinateur avec le monde extérieur. Les télécommunications existaient depuis longtemps, et permettaient notamment de transporter des signaux analogiques comme la voix. Encore fallait-il transmettre des données sous forme digitale, compréhensible par les ordinateurs. C’est ainsi que ce sont construits diverses formes de « couplage » de l’unité centrale des mini-ordinateurs pour les rendre capables d’interagir avec le monde extérieur en temps réel.

Les enjeux techniques initiaux du SDART

C’est à ce pari que prétendait répondre le SDART : faire fonctionner des équipements utilisant de nouvelles techniques numériques en les reliant avec les moyens de télécommunications existants pour remplir les fonctions de téléconduite du réseau de transport d’électricité.

Assez naturellement, on espérait ainsi profiter de nouvelles opportunités fonctionnelles, et rendre le métier de conducteur de réseau électrique plus performant : capacité à mieux connaitre l’état du réseau, à réagir plus vite et mieux, à conduire le réseau plus prêt de ses limites, etc…

Il est intéressant de noter que la principale qualité attendue de l’informatique résidait dans sa supposée souplesse et adaptabilité.

Le vocabulaire (anglais) de l’époque ne parlait-il pas de « software » et de « hardware » ? On voulait ainsi opposer ce qui est « hard » et donc rigide, à ce qui est « soft » et donc souple.

On espérait ainsi que le matériel, le « hardware », serait installé une fois pour toute, si possible avec des coûts en baisse au fur et à mesure du déploiement d’un nombre croissant d’équipements, alors que le « software » (sa traduction en logiciel n’existait pas encore) ne couterait rien ou presque. Certes, on s’attendait à des coûts de développement initiaux assez élevés, mais qui s’amortiraient sur le nombre d’équipements, et surtout, qui seraient très faibles lors des adaptations ultérieures.

On sait aujourd’hui que les choses ont été très différentes.

Les coûts des matériels informatiques ont certes fortement baissé, mais pour des raisons très différentes, lors de l’apparition de l’informatique de masse destinée au grand public.

On sait ainsi que la taille des équipements a fortement diminué, et que leurs performances se sont accrues dans de très grandes proportions (cf la fameuse loi de Moore qui prévoyait dès 1965 un doublement du nombre de transistors par circuit de même taille, à prix constants, tous les 18 mois, ce qui s’est vérifié jusque-là).

Quant au logiciel, il s’est révélé très couteux aussi bien en développement initial qu’en maintenance, et ses couts ne sont finalement acceptables qu’en regard de la taille du marché.

Une autre caractéristique de l’informatique était très présente dans l’esprit des concepteurs du SDART : la capacité d’un système numérique à s’autotester pour alléger le travail de l’exploitant et améliorer la sûreté de fonctionnement. On verra que cet objectif a été atteint, puisque la qualité des téléinformations a globalement augmenté.

Pour le reste, il fallait surtout commencer par vérifier la faisabilité d’une téléconduite informatique, compte tenu des contraintes techniques auxquelles étaient confrontés les pionniers de l’informatique temps réel à ses débuts.

Les chapitres à examiner concernent :

• Le comportement des équipements informatiques dans un environnement industriel

• La transmission des données numérisées

• Les performances « temps réel » des calculateurs

• La sûreté de fonctionnement

• La description des données de téléconduite

L’environnement « hostile » des équipements numériques

Les premiers calculateurs informatiques ont été installés dans des salles spécialement équipées pour les accueillir. Un soin particulier devant être accordé à la température de fonctionnement, ces salles étaient et sont encore le plus souvent climatisées.

Les équipements de téléconduite, au PC comme au PA sont eux prévus pour fonctionner dans l’environnement d’un poste électrique, avec des contraintes beaucoup plus sévères.

Deux contraintes ont fait l’objet de mesures particulières : la température et l’environnement électromagnétique.

C’est ainsi que des climatisations ont fait leur apparition dans les salles de « télécommunications » initialement conçues pour accueillir les différents équipements de téléphonie et télétransmissions pré existants.

Dans la continuité du travail accompli depuis plusieurs années pour les équipements de téléphonie, un soin particulier a été accordé à l’alimentation électrique. C’est pourquoi le choix a été fait d’une alimentation à courant continu avec une alimentation secourue par batterie. Alors que les mini calculateurs étaient généralement alimentées en 220 V alternatif, et il a fallu faire développer par les constructeurs des alimentations spécifiques.

Ainsi, les premiers calculateurs de l’EDT de PCG ne s’appelaient pas Mitra 15 (leur nom d’origine), mais FDE 15 T.

(Pour l’anecdote, mais ce serait à vérifier, la CII a choisi ce nom codé pour qu’on reconnaisse EDF sans le nommer, avec le « T » de « transport »)

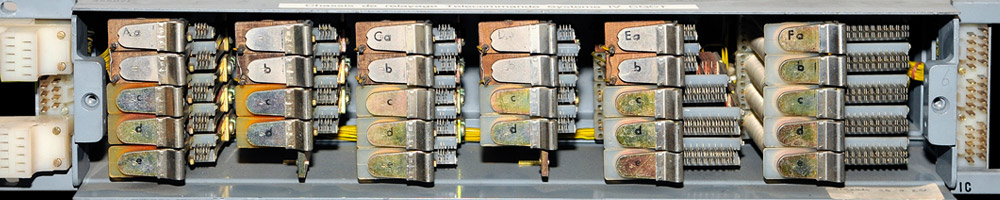

De nombreux essais ont été nécessaires, sur le PC mais surtout sur les PA, pour vérifier qu’ils supportaient l’environnement électromagnétique sévère d’un poste électrique. Ce sont les cartes « coupleurs » (les « handlers ») qui se sont révélées les plus fragiles, et de nombreuses évolutions de version ont été nécessaires. Cela a engendré de nombreux retards sur les premiers développements.

Ces phénomènes étaient déjà connus des spécialistes des télécommunications d’EDF qui, par exemple, connaissaient bien la fameuse « NS24 » (note de service 24 des télécommunications) qui édictaient des règles à respecter pour éviter des perturbations réciproques entre télécommunications du domaine public et postes électriques. Le fait nouveau provenait de la technologie numérique utilisée, et du manque de compétence, voire d’intérêt, des informaticiens pour les questions relatives aux « courants forts ».

Ces différents points ont fait l’objet de travaux internationaux à la CIGRE ou à la CEI (Comité 57), pour normaliser les niveaux de contraintes auxquels devaient être soumis les équipements de téléconduite dans les postes électriques.